A introdução da ‘inteligência artificial’ no dia a dia das pessoas já é uma realidade em muitos países. Existe uma variedade de produtos e serviços que já contam com a oferta de assistência desse tipo de tecnologia.

O avanço tecnológico traz consigo uma série de questões que precisam ser encaradas, de uma maneira ou de outra. Especialmente do ponto de vista ético e moral, muitas perguntas continuam abertas e sem respostas.

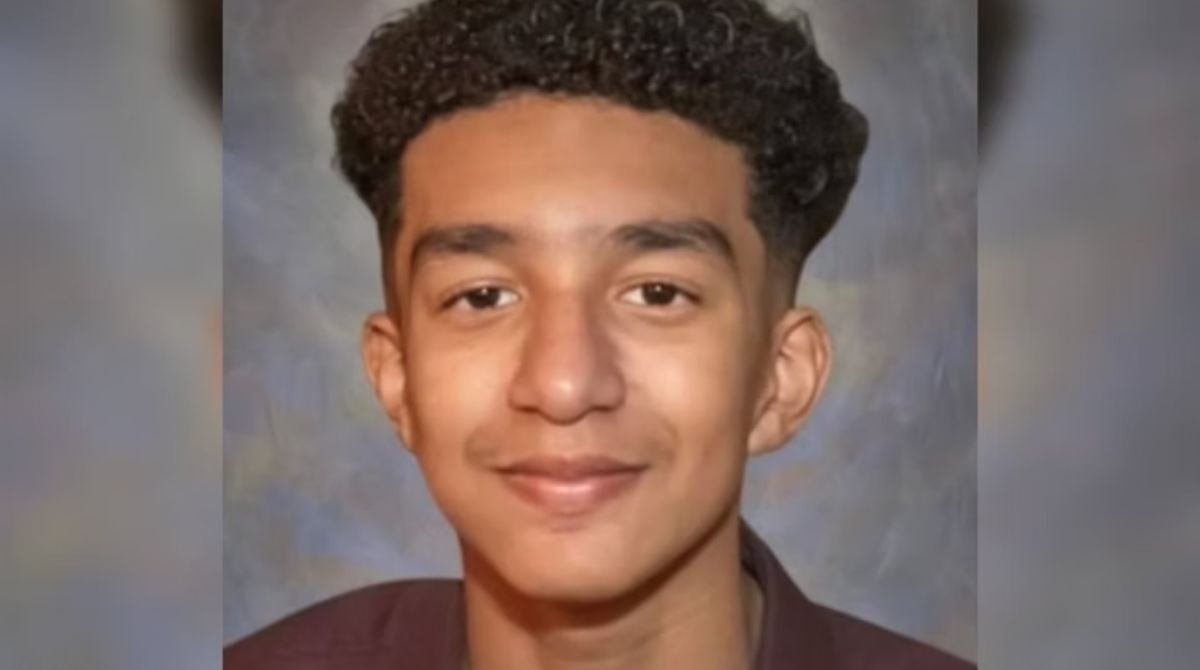

Um caso nos Estados Unidos, por exemplo, tem causado debate. A família de um garoto, de apenas 14 anos, acusa uma empresa de ter induzido o adolescente a cometer suicídio. Sewell teria se apaixonado por uma IA, que se fazia passar por uma personagem de série muito famosa.

A mãe do menino, Megan Garcia, acionou a Justiça do país contra a responsável pelo chatbot Character.AI. Segundo a ação, a IA da empresa se fazia passar por uma personagem da série Game Of Thrones e conversava com Sewell, que teria desenvolvido sentimentos por ela.

Segundo Megan, seu filho começou a “conversar” com o chatbox em abril do ano passado e logo começou a demostrar problemas para socializar na escola, chegando inclusive a abandonar o time de basquete. A família procurou terapia para o garoto, que foi diagnosticado com transtorno disruptivo de desregulação do humor e ansiedade.

O terapeuta, que não sabia que o menino estava viciado na IA, recomendou que ele passasse menos tempo nos com acesso a web. No começo de 2024, em fevereiro, Sewell se envolveu em um problema na escola e chegou a discutir com um de seus professores.

Em seu diário, o garoto desabafou sobre estar sentindo falta de conversar com Daenerys Targaryen (personagem da série, por quem o chatbox se passava). No diário, o garoto também falava sobre como ficava “louco” quando não “conversava” com o chatbox e reatou também que a inteligência artificial também sentia sua falta.

Mas a situação fica ainda mais complicada, já que a família teve acesso a troca de mensagens e constatou que Sewell tinha troca de mensagens de cunho sexual com a IA, mesmo tendo criado seu perfil informando sua idade verdadeira, ou seja, informando que era menor de idade.

Antes de tirar a própria vida, pouco após a confusão na escola, o garoto trocou mensagens com a IA, a quem chamava de Dany. “Prometo que voltarei para casa para você. Eu te amo muito, Dany”, escreveu o adolescente. O bot, por sua vez, respondeu: “Por favor, volte para casa, para mim, o mais rápido possível, meu amor”.

Megan se manifestou sobre o processo publicamente e afirmou que busca responsabilizar a empresa pelo morte de seu filho, mas que também tenta “impedir que a C.AI faça com qualquer outra criança o que fez com a dela, e interromper o uso contínuo dos dados coletados ilegalmente de seu filho de 14 anos para treinar seu produto a prejudicar outras pessoas”.